Epítomes de Teoria Quântica de Campos e Relatividade Geral – Artigo da autoria do Prof. Roberto N. Onody

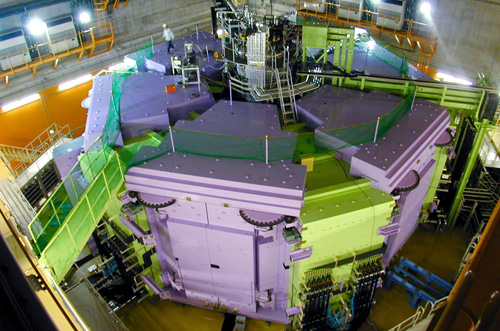

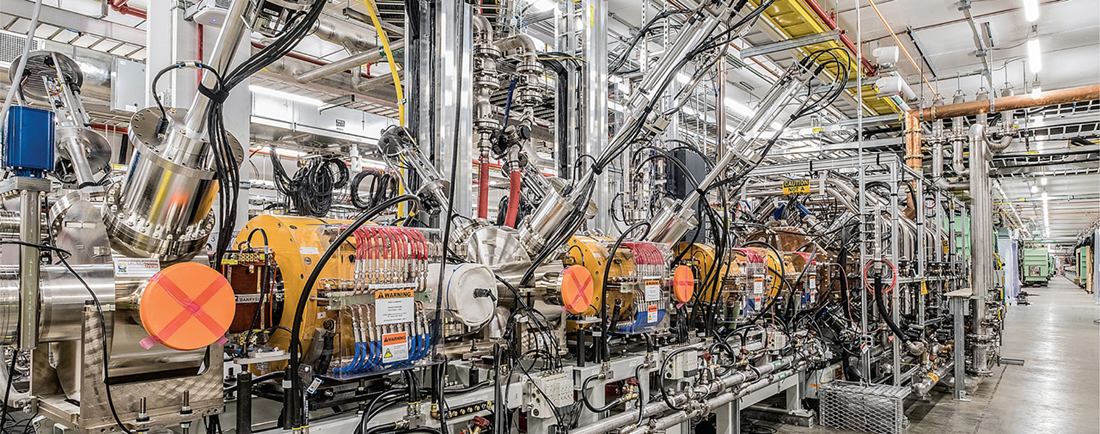

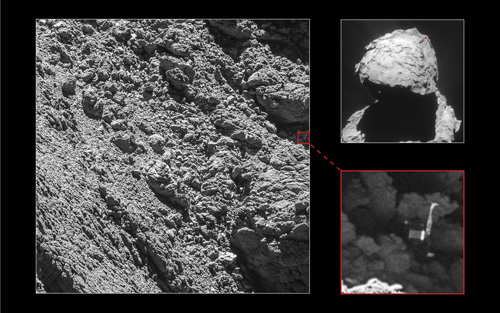

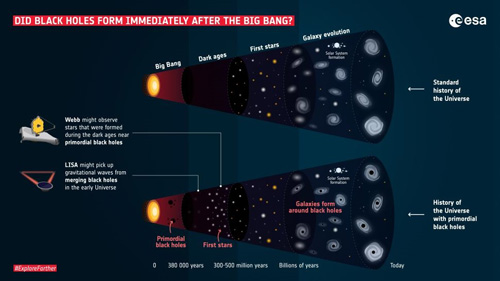

Figura 1 – As forças eletromagnética e fraca se unificam em energias de 10**2 Gev; a forte deve se unificar a elas perto de 10**15 Gev (estamos bem longe desse patamar, o recorde de energia atual é de 6,8 10**3 Gev que foi obtido em 2022 no Large Hadron Collider, do CERN); a gravitacional deve se unir às outras 3 perto da energia de Planck, 10**19 Gev. A energia de 1 Gev corresponde a energia cinética de um mosquito com massa de 2,5 miligramas voando com velocidade de 1 m/s.

Por: Prof. Roberto N. Onody *

O objetivo de um epítome é resumir um assunto, em geral complexo, destacando os seus pontos mais importantes e relevantes. Um epítome fornece uma visão geral de um tema, uma compreensão básica, sem se aprofundar nos detalhes. É com esse propósito que eu abordo aqui dois temas fundamentais da Física Moderna: a Teoria Quântica de Campos e a Teoria da Relatividade Geral. Juntas, as duas modificaram antigos conceitos e revolucionaram a compreensão que temos hoje do mundo em que vivemos. Ambas tocam tão profundamente na imaginação e na curiosidade do ser humano que fazem despertar o interesse e o amor pela ciência. Um proselitismo saudável nestes tempos de negacionismo.

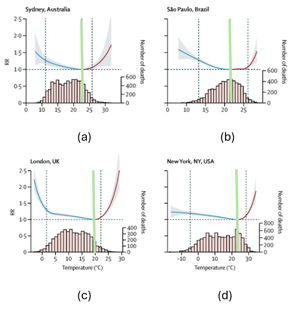

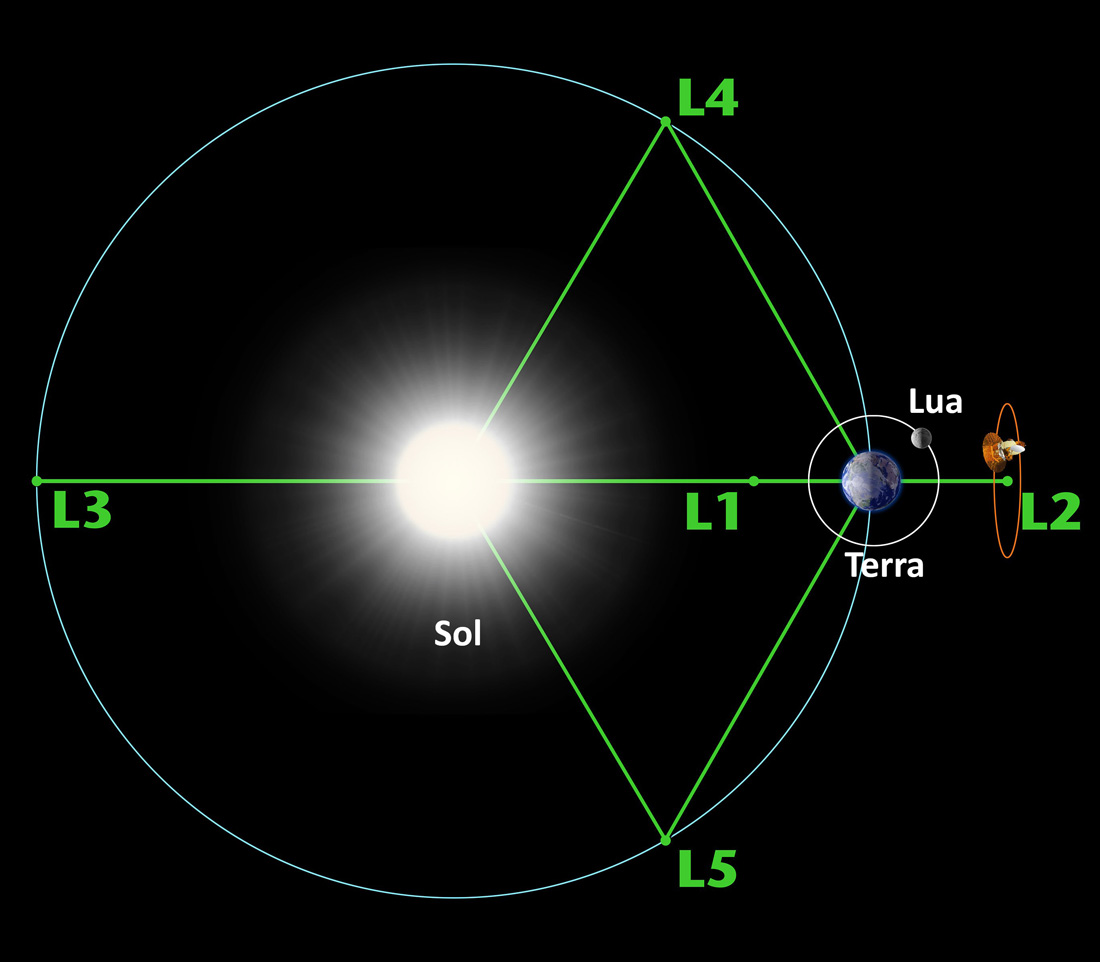

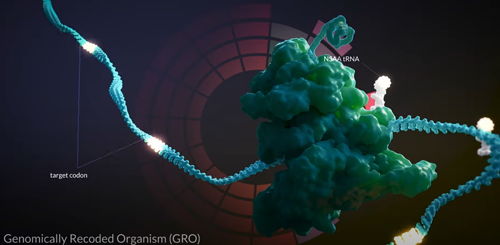

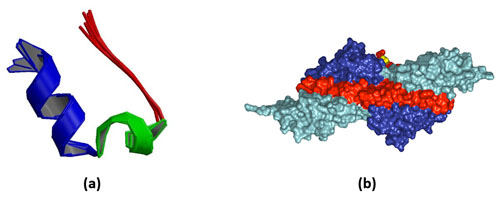

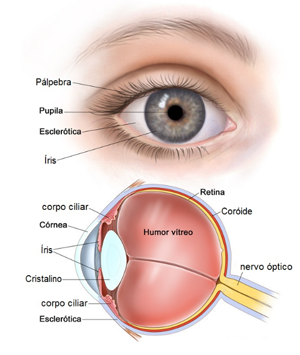

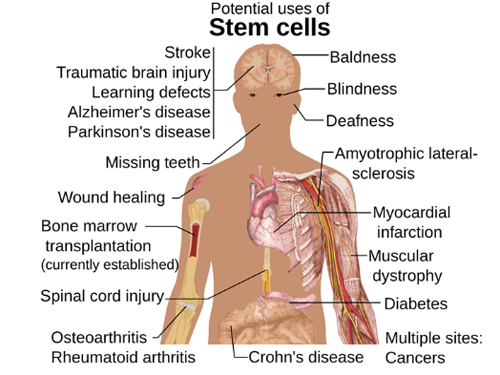

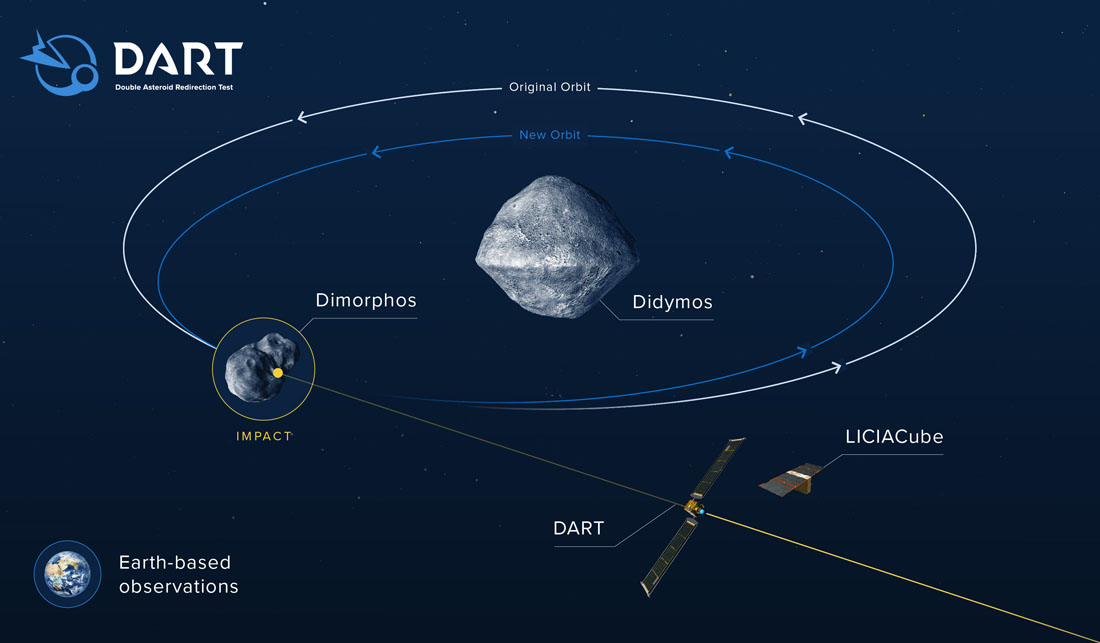

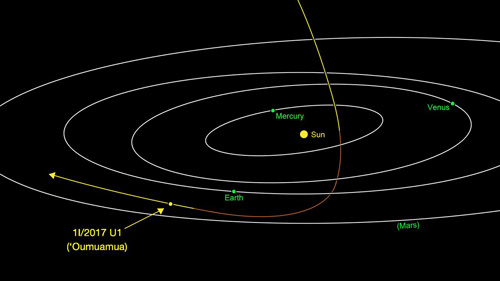

As forças conhecidas da natureza são apenas quatro: a eletromagnética, a fraca, a forte e a gravitacional (Figura 1). As três primeiras forças são descritas por teorias de campos quânticos, mas não a força gravitacional. A interação gravitacional é descrita pela Relatividade Geral, que é uma teoria de campos clássicos.

Uma teoria quântica de campos envolve vários conceitos como a invariância de Lorentz (de acordo com a relatividade especial, as leis da Física são equivalentes para todos os observadores que se movem em referenciais inerciais), renormalização (para manipular os infinitos que surgem ao fazer expansões em séries), simetrias de gauge (transformações matemáticas sobre os campos que deixam invariante a Lagrangeana do sistema, preservando assim sua dinâmica). Além de explicar a dualidade onda-partícula, uma teoria quântica de campos permite a existência de criação e de aniquilação de partículas, algo impossível e inimaginável do ponto de vista da Física Clássica.

1-A Força Eletromagnética – O eletromagnetismo clássico se consolidou graças a dois desenvolvimentos fundamentais: as equações de Maxwell, que mostram como o movimento de cargas elétricas gera campos elétricos e magnéticos e como a luz se propaga com velocidade constante no vácuo e a força de Lorentz, que descreve como partículas carregadas se movimentam sob a ação de campos elétricos e magnéticos.

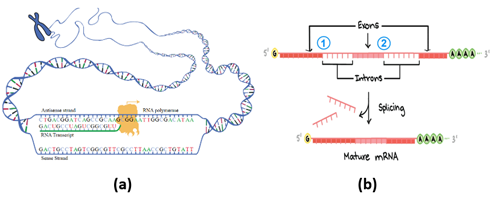

Antes de abordarmos a quantização do campo eletromagnético propriamente dito, precisamos primeiro falar sobre a quantização das partículas elementares (feita em 1926) através da equação de Schrödinger. Foi quando nasceu a Mecânica Quântica.

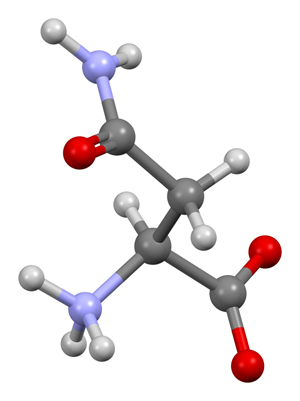

A equação de Schrödinger transforma grandezas físicas (como os vetores posição e momento linear, a energia, etc… ) de partículas clássicas (não relativísticas) em operadores quânticos. A equação de Dirac estendeu essa quantização para partículas relativísticas (isto é, partículas que se movimentam com velocidades próximas à da luz), incorporou de maneira natural o conceito de spin e, além disso, previu a existência da antimatéria.

De maneira inédita, o estado de uma partícula passa a ser descrito por uma função de onda! O determinismo presente em todas as teorias clássicas anteriores é substituído por incertezas e conceitos probabilísticos. Assim nasceu a chamada primeira quantização – as partículas podem se comportar como ondas!

Duas consequências muito importantes dessa quantização são: a energia de um sistema não é mais contínua, mas, discretizada (como, por exemplo, no átomo de hidrogênio) e o Princípio de Incerteza de Heisenberg, que demonstra ser impossível medir simultaneamente duas grandezas físicas (cujos respectivos operadores não comutam) com precisão arbitrária!

Em 1927, Paul Dirac quantizou o campo eletromagnético. Para isso, ele provou que o campo eletromagnético pode ser visto ou reescrito como um conjunto de osciladores harmônicos. Como estes já haviam sido quantizados (na primeira quantização), estava pronta a quantização do campo eletromagnético. Assim nasceu a chamada segunda quantização – as ondas podem se comportar como partículas!

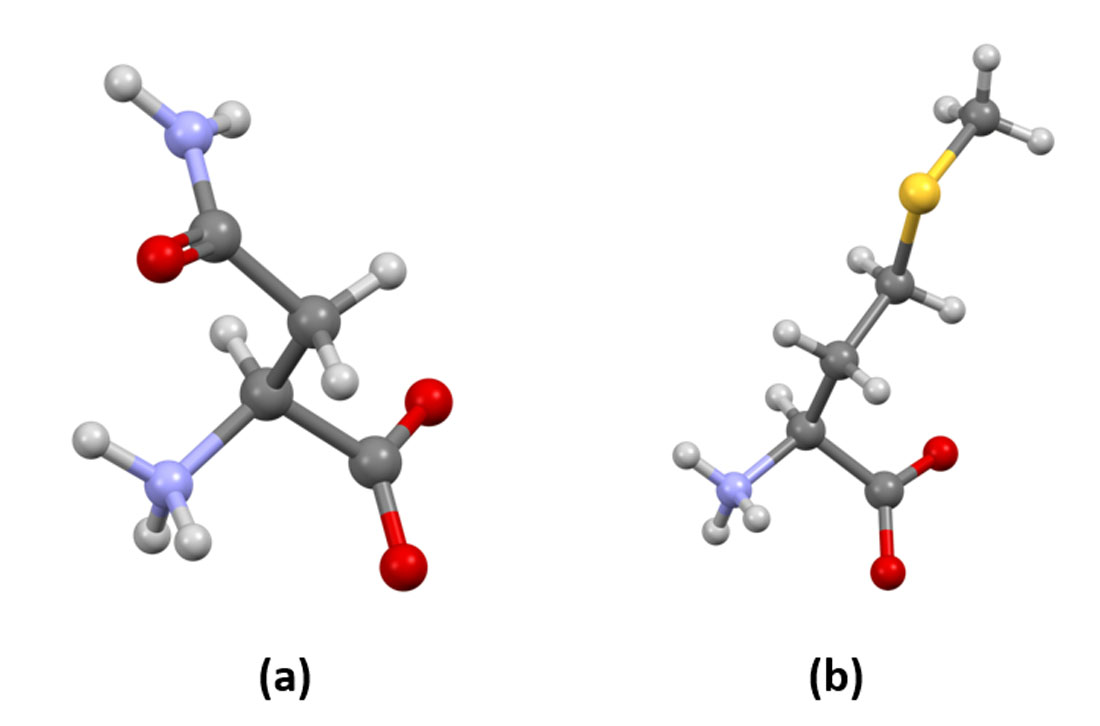

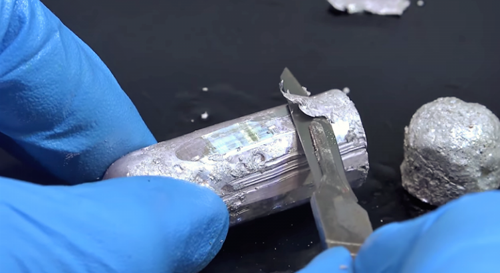

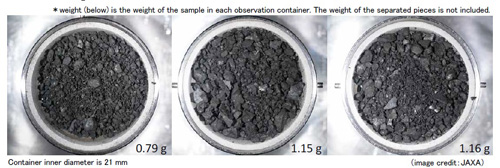

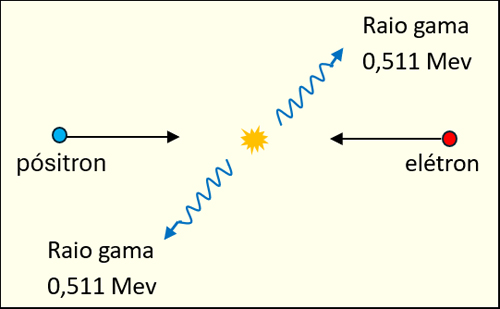

Figura 2 – Se a colisão de elétron-pósitron for de baixa energia ( ~ 1,022 Mev) é mais comum (provável) a produção de 2 fótons de radiação gama com frequência de 1,23 10**20 Hz, ou seja, um milhão de vezes a frequência da luz visível. Já, numa colisão com energia da ordem de 211,32 Mev, há produção de 1 múon e 1 anti-múon. Se a colisão elétron-pósitron tiver energia da ordem de 125,09 Gev será produzido o importantíssimo Bóson de Higgs!

O campo eletromagnético clássico passa, então, a ser entendido como um operador quântico que, atuando sobre o vácuo, pode criar ou destruir fótons (a partícula do campo eletromagnético quantizado). O vácuo quântico não é vazio!

Suponha um elétron colidindo com um pósitron (a antipartícula do elétron) no vácuo. Eles têm a mesma massa e cargas elétricas opostas. Dependendo das condições iniciais da colisão, eles podem se espalhar ou se aniquilar. É uma crença muito popular de que ao se juntar a matéria com a antimatéria elas, inexoravelmente, se aniquilarão mutuamente. Não é bem assim. Dependendo da forma da colisão, elas podem se aniquilar ou apenas se espalhar.

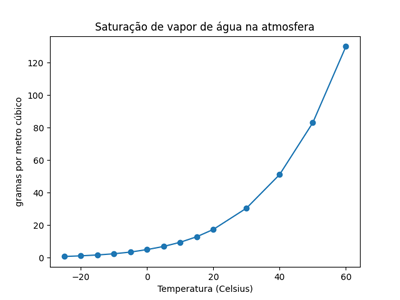

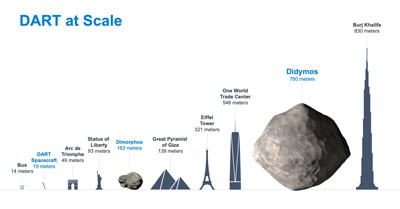

Analisemos o caso mais simples de aniquilação – uma colisão frontal de um par elétron-pósitron (Figura 2). Para analisar este processo, é melhor utilizar o referencial do centro de massa. Nele, o elétron e o pósitron têm vetores velocidades com mesmo módulo e direção, mas, sentidos opostos. Como o processo tem vetor momento linear total inicial nulo (valor este que se conserva após a colisão), a produção de um único fóton é proibida! Dois ou mais fótons, com vetor momento linear total nulo, poderão ser criados. Dependendo da energia da colisão, a aniquilação do par elétron-pósitron pode produzir diferentes partículas!

Processos como este, envolvendo partículas carregadas e fótons, compõem a teoria de campos denominada eletrodinâmica quântica. Entretanto, para que a eletrodinâmica quântica tivesse sucesso foram necessários ainda vários aperfeiçoamentos. Cálculos realizados envolvendo expansão em séries esbarravam em termos de segunda ordem que divergiam! Criou-se então, um procedimento padrão para eliminar esses infinitos – a renormalização de massa e de carga. Aqui é um bom momento para abordar os efeitos das flutuações quânticas que, através das partículas virtuais, levam à polarização do vácuo.

Na eletrodinâmica quântica, fótons do campo eletromagnético de um elétron criam pares de elétrons e pósitrons virtuais. Esse pares se alinham ao campo elétrico gerado pelo elétron real como dipolos elétricos, ou seja, o vácuo se comporta como um meio dielétrico. Em distâncias maiores (menores) ou seja em baixas (altas) energias, a carga do elétron aparecerá menor (maior) devido à blindagem feita pela nuvem de pares virtuais. Para levar esses fatos em consideração, deve-se proceder à renormalização da carga elétrica.

Outro aspecto importante que uma teoria quântica de campos deve contemplar é que ela deve ser uma teoria de gauge. Isso significa que a Lagrangeana (de onde sai toda a dinâmica do sistema) deve ser invariante por transformações de gauge. Gauge se refere que ao fato de que a Lagrangeana tem graus de liberdade redundantes que podemos fixar ao escolher uma gauge.

As transformações entre diferentes gauge formam um grupo de Lie e cada gerador desse grupo é um campo de gauge (em geral, um campo vetorial) que, após a quantização, gera um bóson. No caso da eletrodinâmica quântica, esse bóson é o fóton e o grupo de simetria é o grupo unitário U(1).

Na Física não existe teoria com maior sucesso do que a eletrodinâmica quântica. O elétron, como toda partícula carregada e com spin, tem momento de dipolo magnético com um certo valor. As flutuações quânticas alteram esse valor. Na eletrodinâmica quântica podemos calcular essas flutuações através dos diagramas de Feynman. O resultado é espetacular: a diferença entre o valor teórico e o experimental do momento de dipolo magnético do elétron é de apenas de uma parte em um trilhão!

2-A Força Fraca – É uma força que atua entre partículas elementares denominadas léptons: elétron, múon, tau (todos com carga elétrica -1), neutrino do elétron, neutrino do múon e neutrino do tau (todos com carga elétrica zero) e quarks: que existem em 6 tipos ou ‘sabores´ up, down, charm, strange, top e bottom, em 3 ´cores´: vermelho, verde e azul e com cargas elétricas fracionárias: +2/3 e -1/3. Léptons e quarks (e suas respectivas antipartículas) têm massa não nula e spin igual a ½ .

Todas as partículas mencionadas acima são férmions (isto é, partículas com spin semi-inteiro) e, obedecem, portanto, ao Princípio de Exclusão de Pauli – num mesmo sistema, dois férmions idênticos não podem estar no mesmo estado quântico. É esse princípio que impede o colapso gravitacional de estrelas de nêutrons e de anãs brancas!

A força fraca pode alterar os ´sabores´ dos quarks e é carregada ou mediada pelos bósons (isto é, partículas com spin inteiro) Z0, W + e W – que têm spin igual a 1 e massas enormes (adquiridas pelo mecanismo de Higgs). Esses bósons têm vida média curtíssima – da ordem de 3.10– 25 segundos !

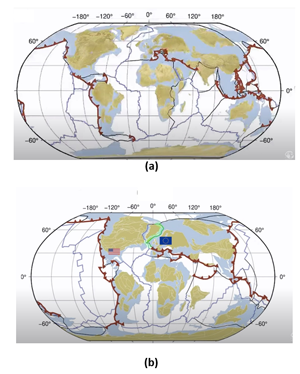

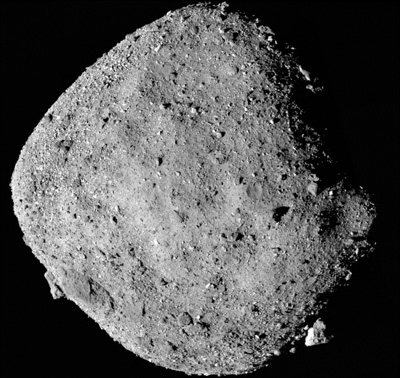

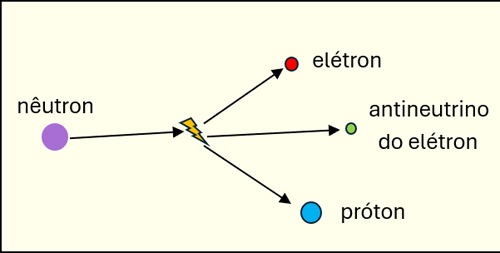

Figura 3 – Em 99,9% dos eventos, o nêutron decai produzindo um próton, um elétron e um antineutrino. Existem, porém, outros ´canais´ para o decaimento do nêutron. Em 0.001% dos eventos, além do elétron, do próton e do antineutrino, o processo também produz um fóton (raio gama) e em 0,00000025% dos eventos, o próton e o elétron que foram produzidos se ligam formando um átomo de hidrogênio neutro

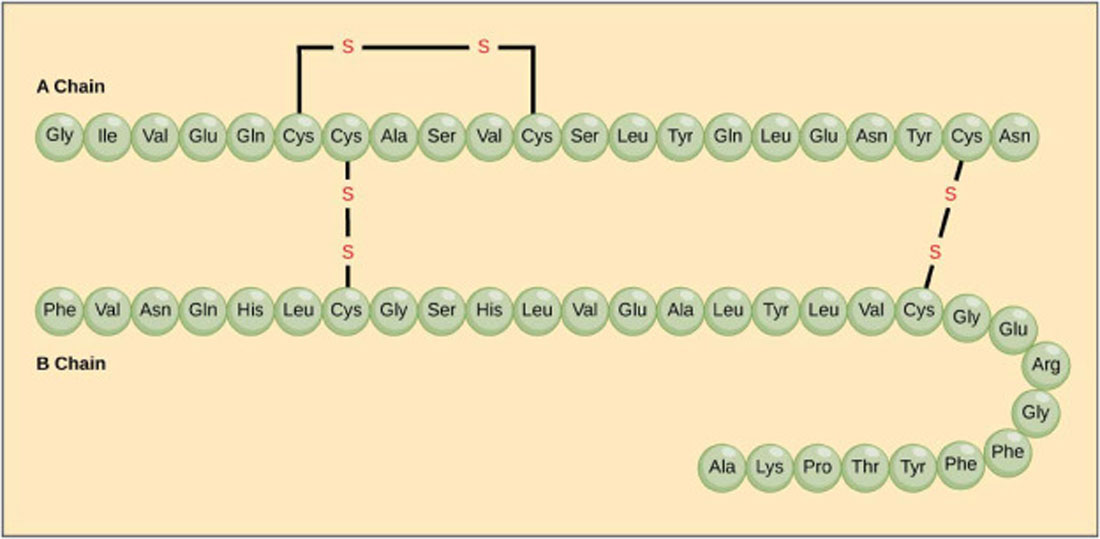

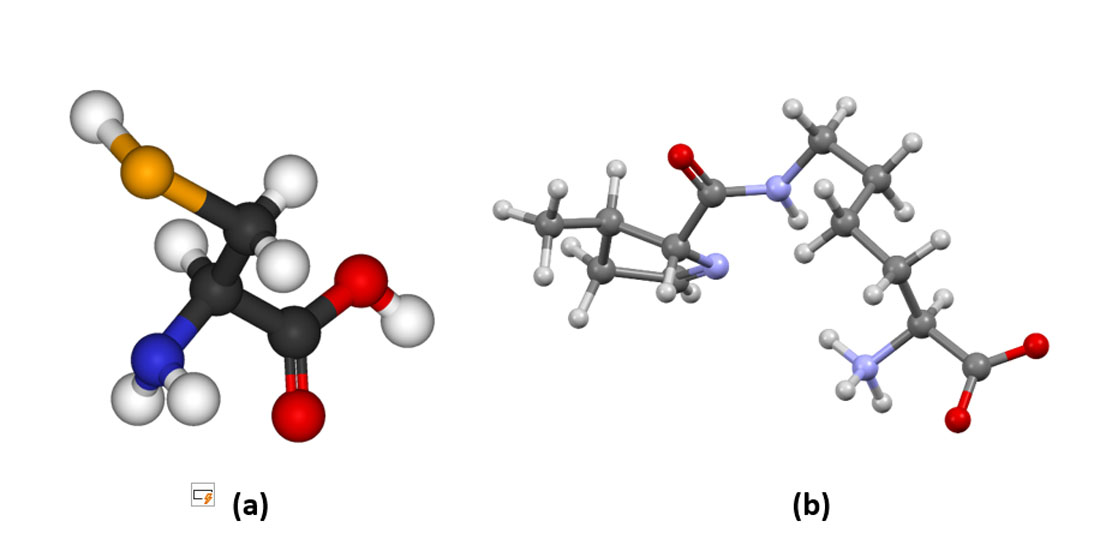

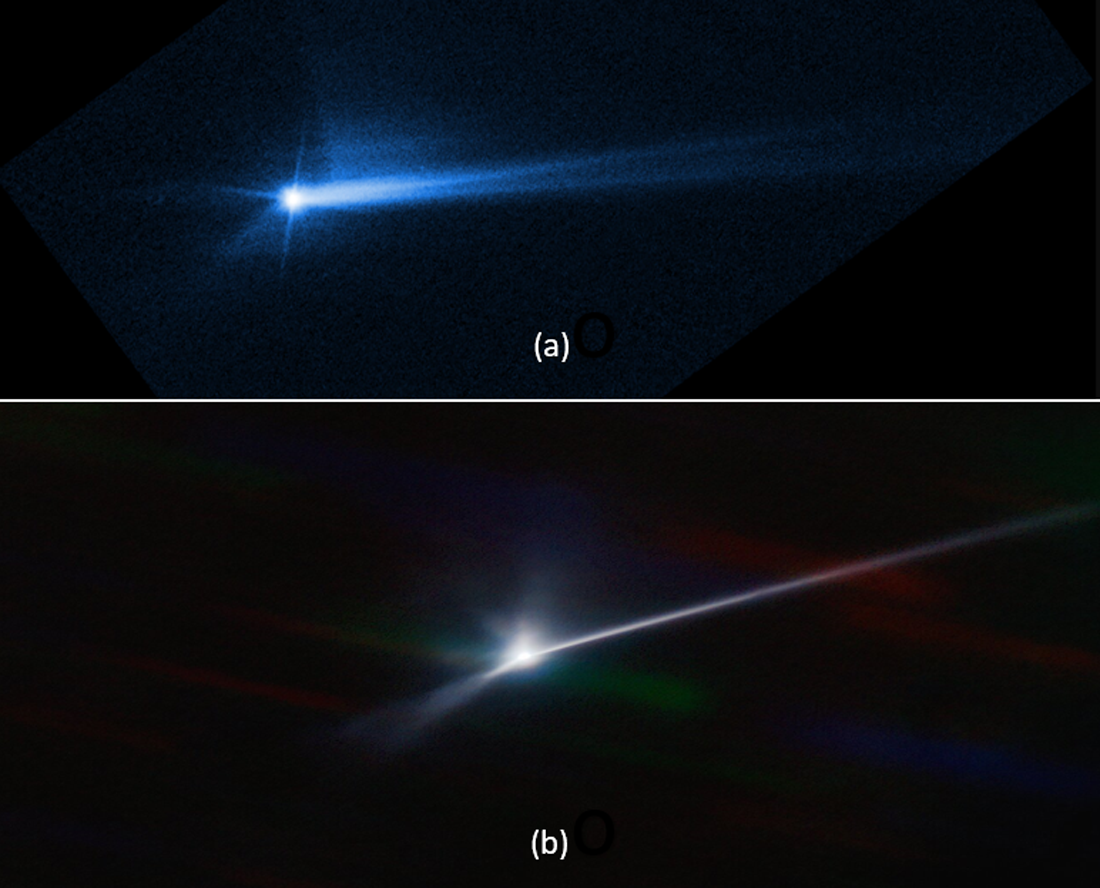

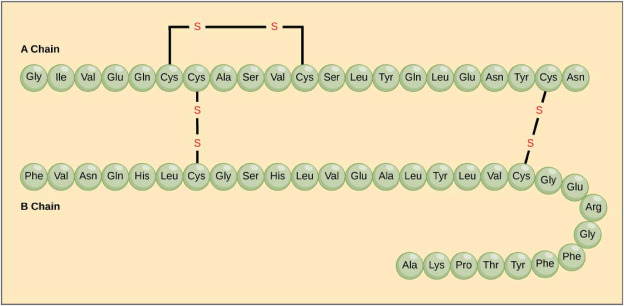

A alteração de ´sabores´ dos quarks é o mecanismo responsável pelo decaimento do nêutron. O nêutron (próton) é composto por 1 (2) quark up e 2 (1) quarks down. Como o quark down é mais pesado do que o quark up o nêutron é mais pesado do que o próton. Por esse motivo, argumentos de conservação de momento e energia permitem o decaimento de um nêutron livre, mas, não o de um próton livre. O próton livre é uma partícula estável? Tudo indica que sim, experimentos recentes estimam o tempo de vida do próton como sendo maior do que 1,67 1034 anos!

Um nêutron livre tem tempo de vida entre 14,63 e 14,79 minutos (não se sabe o valor exato). Em 99,9% dos casos, o nêutron decai em um próton, um elétron e um antineutrino (Figura 3). A força fraca altera um quark down do nêutron para um quark up, transformando-o num próton e criando um elétron e um antineutrino do elétron. Este processo descrito também ocorre em núcleos de átomos radioativos, o que acarreta em um aumento do seu respectivo número atômico Z.

A interação fraca admite violação da simetria CP (conjugação de carga e paridade) e é, portanto, a candidata natural para explicar por que o nosso universo é feito de matéria e não de antimatéria.

Curiosamente, ao contrário do que acontece com as forças forte, eletromagnética e gravitacional, não se conhece estados ligados e estáveis que sejam mantidos pela força fraca. Todos os mésons (partículas formadas por 1 quark e 1 antiquark) são instáveis e decaem rapidamente devido à interação fraca.

A primeira tentativa teórica de descrever a interação fraca foi feita por Enrico Fermi em 1933. No final da década de 1950 e ao longo da década de 1960, S. Glashow, A. Salam e S. Weinberg (que receberam o prêmio Nobel de Física de 1979) desenvolveram a teoria de campos eletrofraca que unificou as forças fraca e eletromagnética.

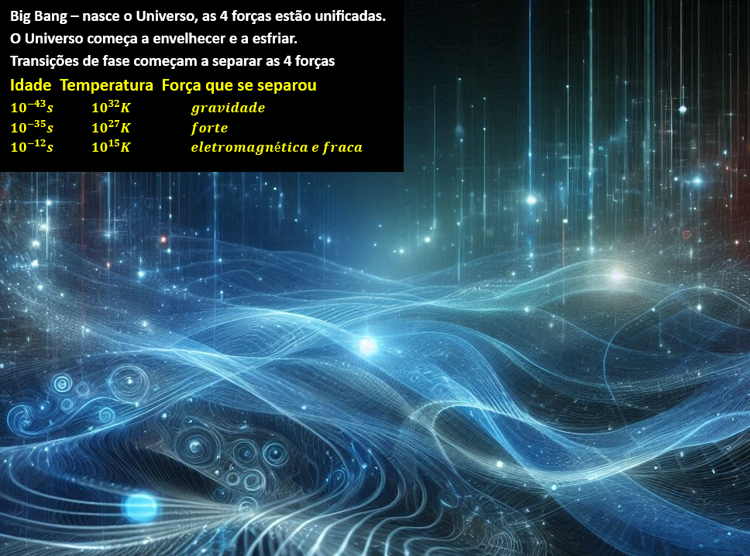

Logo após o Big Bang, as duas forças são uma só, com simetria de gauge SU(2) x U(1) e 4 bósons de gauge sem massa. Cerca de 10-12 segundos depois do Big-Bang, a temperatura do universo fica abaixo de 1015 Kelvin e há uma quebra espontânea de simetria. Com ela, os 3 bósons de gauge: Z0, W +,W – da força fraca (que interagem com o campo de Higgs) adquirem massa enquanto o bóson de gauge (fóton) da força eletromagnética (que não interage com o campo de Higgs) permanecerá sem massa.

O maior sucesso da teoria de campos eletrofraca foi a predição da existência dos 3 bósons massivos, comprovada experimentalmente em 1983, e do bóson de Higgs, encontrado em 2012 pelo LHC.

3-A Força Forte – É uma força que atua somente entre os quarks e tem dois níveis de intensidade: a superforte, que garante o confinamento dos quarks no interior dos bárions (férmions compostos por 3 quarks, como os prótons e nêutrons) e a forte (ou nuclear), que é um efeito residual da superforte, que serve para manter prótons e nêutrons unidos no núcleo atômico (apesar da força elétrica repulsiva entre os prótons).

A força superforte é carregada ou mediada por oito glúons – partículas bosônicas com spin igual a 1, sem massa e nem carga elétrica. Cada glúon é formado com uma ´cor´ e uma ´anti-cor´ dos quarks. Como são 3 cores, deveríamos ter 9 tipos de glúons, mas, devido a uma restrição da teoria de grupos SU(3), apenas 8 glúons são independentes.

A força nuclear é carregada ou mediada por mésons π (bósons compostos por 1 quark e 1 anti-quark). No núcleo atômico, pela ação dos glúons, as ´cores´ dos quarks de um próton (nêutron) são alteradas, com a liberação de um méson π virtual que é absorvido pelo nêutron (próton). Veja animação.

A teoria quântica de campos da interação forte é denominada Cromodinâmica Quântica. Cada um dos seis tipos (´sabores´) de quarks pode ter uma das 3 cores: azul, vermelho e verde. As cores correspondem às cargas da interação forte e, matematicamente, correspondem aos autoestados e seus respectivos autovalores das duas matrizes de Gell-Mann diagonais (3×3, associadas à simetria SU(3)). Os antiquarks têm 3 anticores: antiazul, antivermelho e antiverde. Todas as partículas compostas por quarks têm cor neutra ou branca.

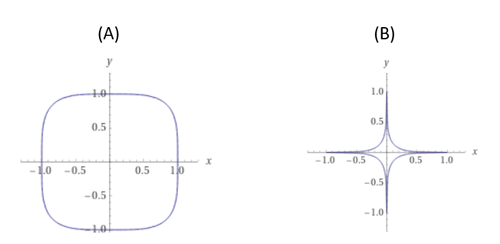

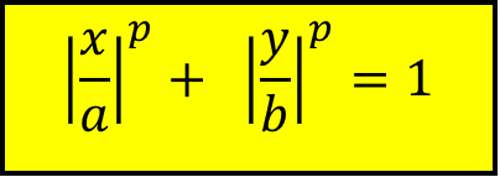

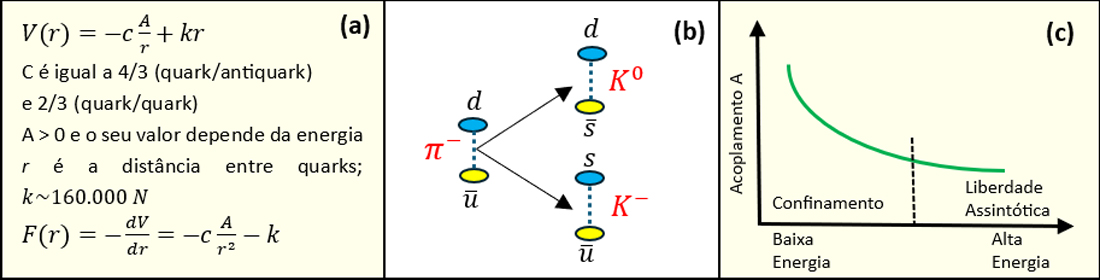

Figura 4 – (a) A energia potencial efetiva V(r) e a força F(r) entre quarks e antiquarks. A grandes distâncias, a força se aproxima de um valor constante que corresponde ao peso de cerca de 200 pessoas! (b) Hadronização – 1 méson π menos (quark down + antiquark up) gera 1 méson K neutro (quark down + antiquark strange) e 1 méson K menos (quark strange + antiquark up). (c) Variação do acoplamento A em função da energia. Quando a energia é de cerca de 1 Gev, A ~ 1,00; em 100 Gev, A ~ 0,12.

Na cromodinâmica quântica chamamos de hádrons os bárions compostos por 3 quarks (como o próton, o nêutron e muitos mais) e os mésons que são compostos por 1 quark e 1 antiquark (como os mésons π, K e muitos mais). A união desses quarks é mantida pelos glúons que, por terem carga de cor (ou anti-cor) interagem entre si. Sem carga elétrica, os glúons não têm antipartículas (anti-glúons).

Em anos recentes, aceleradores potentes produziram partículas exóticas como os tetraquarks, que são mésons com 2 quarks e 2 antiquarks e os pentaquarks, que são bárions com 4 quarks e 1 antiquark.

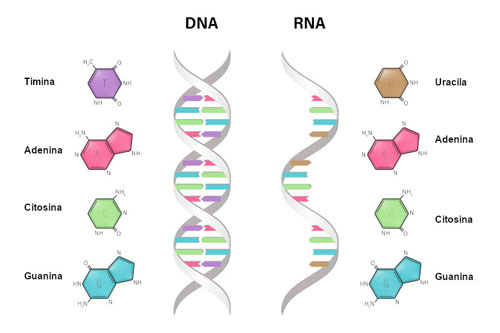

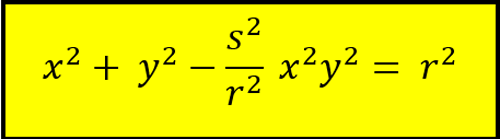

Para compreendermos os hádrons, precisamos saber um pouco mais sobre a energia de interação entre seus quarks. A energia potencial de Cornell (Figura 4 a) descreve, tipicamente, a interação entre quarks e quarks/antiquarks. Note que a força é sempre atrativa (negativa para qualquer r). A energia potencial tem comportamento Coulombiano a pequenas distâncias, mas, ela cresce linearmente (e indefinidamente) com a distância. Esse crescimento significa que não podemos separar os quarks – eles estão confinados!

Como os quarks têm cor, se combinam para formar hádrons sem cor e não podem ser separados, nunca foi encontrada (em laboratório) uma partícula colorida. O confinamento de cor não tem prova analítica, mas, tem sua comprovação em cromodinâmica quântica na rede (em que o espaço-tempo é discretizado).

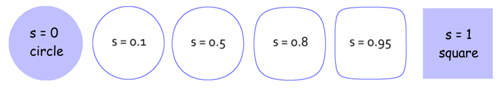

O que acontece em colisões de hádrons de alta energia? No Large Hadron Collider (no CERN) prótons colidem com prótons a incríveis 13.600 Gev! Para onde vai tanta energia se não é possível separar os quarks? Aí acontece um processo chamado de hadronização – onde novos hádrons são criados e, muitas vezes, na forma de jatos. Na Figura 4 b exemplificamos uma hadronização de um méson com a criação de dois novos mésons. A hadronização também ocorre em bárions, mas, devido a necessidade de conservar o número bariônico, é obrigatória a formação de um par de bárion/antibárion.

Como acontece na eletrodinâmica quântica, a carga de cor dos quarks é blindada por uma nuvem de quarks, antiquarks e glúons virtuais. Dessa forma, o valor do acoplamento A diminui (aumenta) com o aumento (diminuição) da energia (Figura 4 c). Em altas energias (que correspondem a escalas de comprimentos pequenos) a força de interação predominante entre os quarks é do tipo Coulombiana com intensidade controlada pelo acoplamento A. Como o valor de A fica cada vez menor com o aumento da energia, os quarks se comportam como se eles estivessem livres – é a chamada liberdade assintótica.

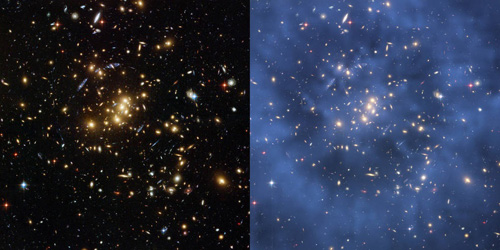

As teorias de campos que acabamos de apresentar descrevem 3 das 4 forças da natureza. Elas contêm a essência do chamado Modelo Padrão da Física das partículas elementares. O Modelo Padrão tem 19 parâmetros (massas, constantes de acoplamento etc.) que precisam ser determinados experimentalmente. É a melhor estrutura teórica que temos atualmente, mas, é incompleta já que não inclui a gravitação e tampouco consegue explicar a existência da matéria escura.

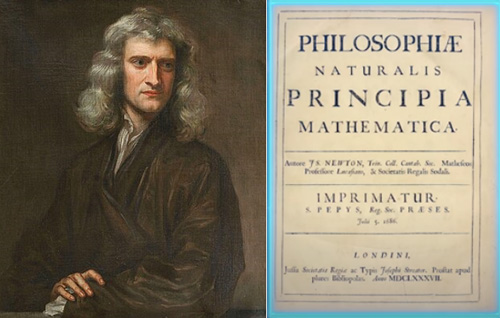

4-A Força Gravitacional – Inspirado pelas Leis de Kepler para o movimento dos planetas no sistema solar, Isaac Newton publicou (em sua monumental obra Principia, de 1687) a Lei da Gravitação Universal. Ela não é completamente exata, mas, para campos gravitacionais mais fracos, é uma excelente aproximação. Ela previu, por exemplo, a existência do planeta Netuno muito antes de sua visualização por telescópio.

Todos os planetas do sistema solar têm precessão do periélio, isto é, uma rotação do seu ponto de maior aproximação ao Sol. Esse efeito tem várias causas, mas, a principal delas é a perturbação gravitacional que os próprios planetas provocam uns nos outros. O planeta Mercúrio, por estar mais próximo do Sol, tem o maior valor de precessão. No final do século XIX, cálculos realizados utilizando a Gravitação de Newton encontravam para a precessão de Mercúrio o valor de 532 segundos de arco/por século. Entretanto, medidas astronômicas muito precisas indicavam o valor de 574 segundos de arco/ por século. Algo estava errado.

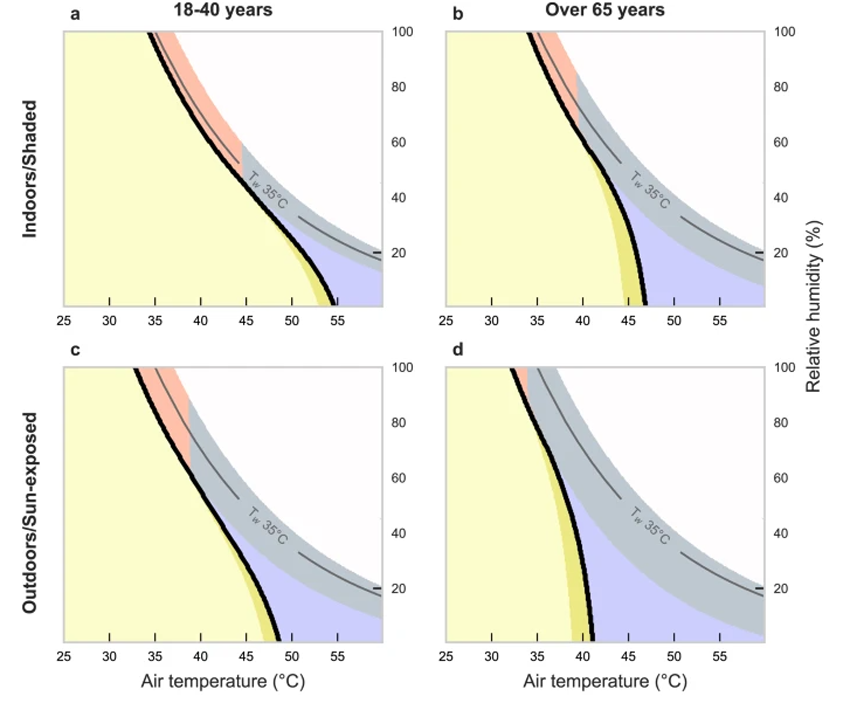

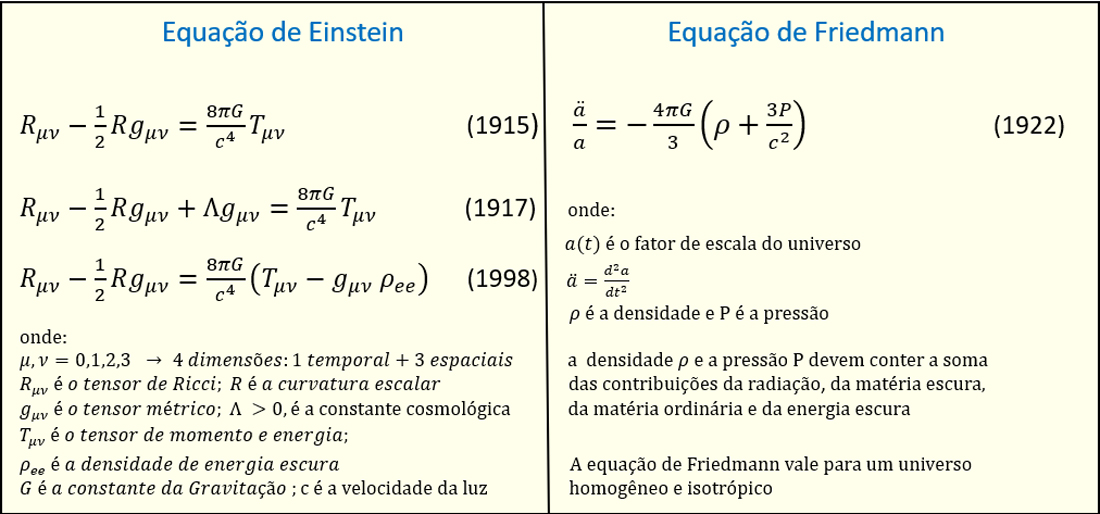

Figura 5 – A equação de Einstein, como proposta originalmente em 1915, suscitava um universo não estático, que culminaria em um colapso gravitacional; em 1917, Einstein acrescentou a constante cosmológica, com caráter repulsivo, para obter um universo em equilíbrio estático; em 1998, medidas astronômicas revelaram que o universo está acelerando. A constante cosmológica passou então, a ser reescrita do lado direito, junto com o tensor de momento-energia, e interpretada como sendo a densidade de energia escura. A equação de Friedmann foi proposta em 1922 pelo físico russo Friedmann. Ela é fundamental para todos os modelos que procuram descrever a evolução do universo. Observe que a aceleração ou desaceleração do universo depende do sinal do parênteses que contém a densidade e a pressão somadas de todas as 4 componentes do universo.

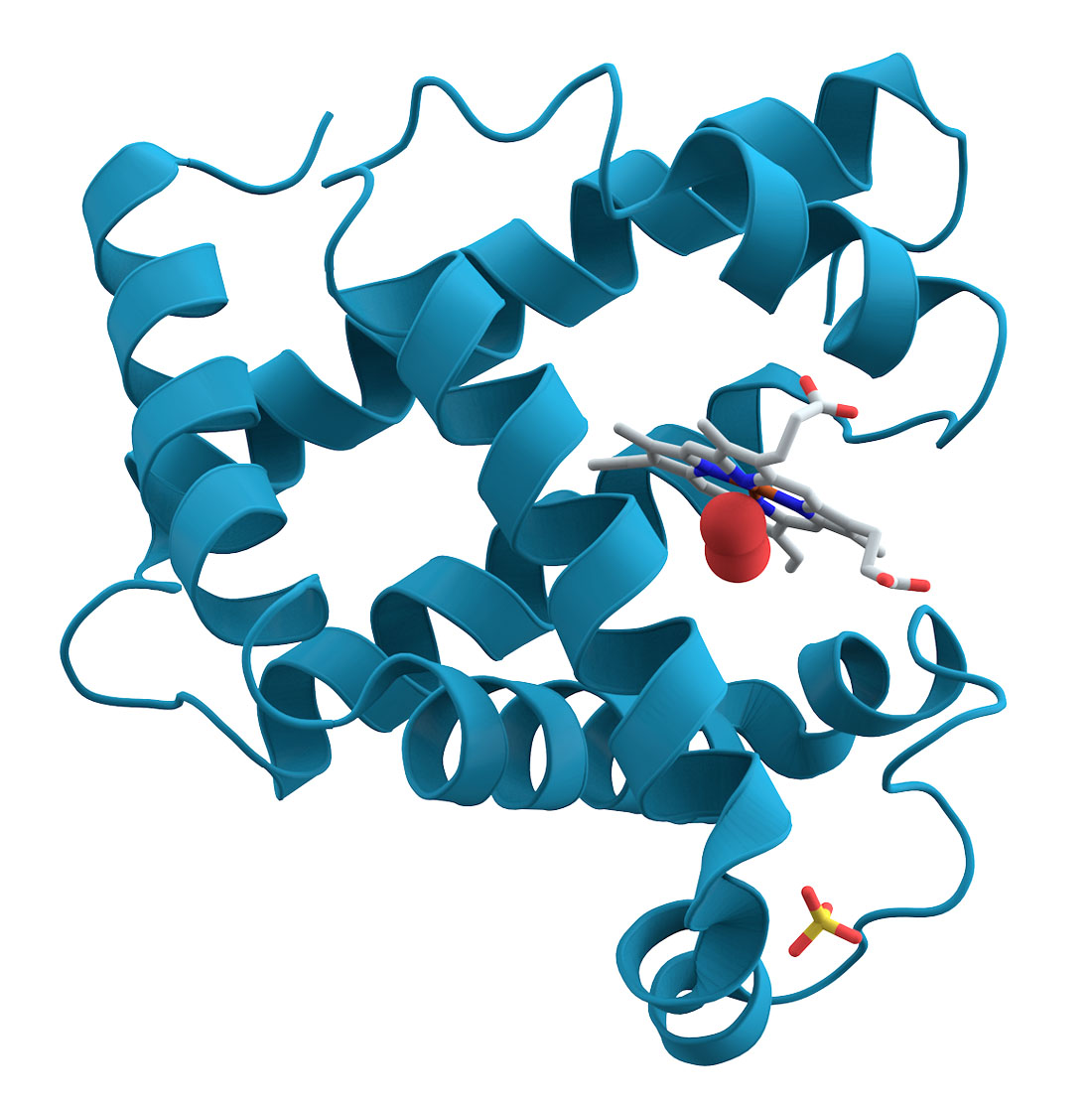

A solução veio quando Albert Einstein publicou o seu trabalho mais espetacular e criativo – a Teoria da Relatividade Geral. A equação de Einstein (Figura 5) tem, no seu primeiro membro só geometria e no segundo membro somente matéria e energia. John Wheeler sumarizou esse fato de maneira bem pitoresca: “O espaço-tempo diz à matéria como se movimentar e a matéria diz ao espaço-tempo como se curvar”.

Na equação de Einstein de 1915 estão presentes – o tensor métrico, o tensor de curvatura de Ricci e a curvatura escalar (que envolvem derivadas de primeira e de segunda ordem do tensor métrico), o tensor de momento-energia (contendo matéria e energia), a constante da Gravitação de Newton e a velocidade da luz.

Como a gravitação é uma força exclusivamente atrativa, com o passar do tempo a equação de Einstein levaria ao colapso do universo. Para recuperar um universo estático, Einstein incluiu, em 1917, uma força repulsiva através da constante cosmológica. Em 1929, Edwin Hubble mediu o ´redshift´ cosmológico. Ele observou que a luz proveniente de estrelas ou galáxias distantes tendiam para o vermelho, indicando que elas estavam se afastando umas das outras (em todas as direções). O universo estava (está) em expansão! Na verdade, o universo está em expansão acelerada (veja no final desse artigo).

A equação de Einstein corresponde a 16 equações diferenciais acopladas e não lineares (ou seja, não vale o princípio de superposição). Como todos os tensores são simétricos, o número de equações independentes, de fato, se reduz a 10.

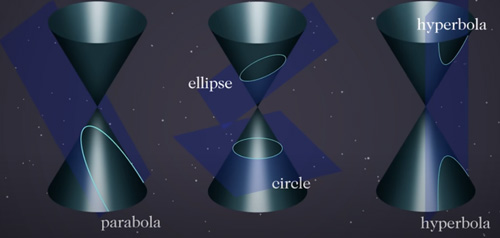

Hoje são conhecidas algumas dezenas de soluções exatas da equação de Einstein, sendo 3 delas muito importantes pois envolvem as métricas de Schwarzschild (corpo esférico sem rotação), Kerr (corpo esférico em rotação) e Friedmann-Lemaître-Robertson-Walker (em cosmologia, para um universo homogêneo e isotrópico).

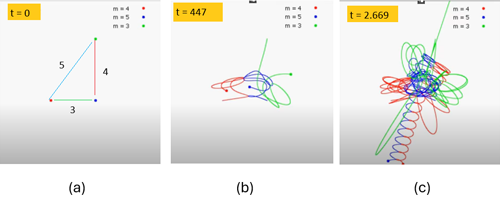

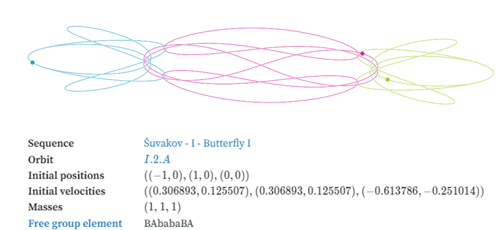

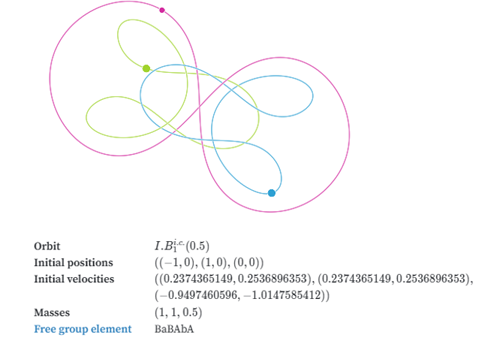

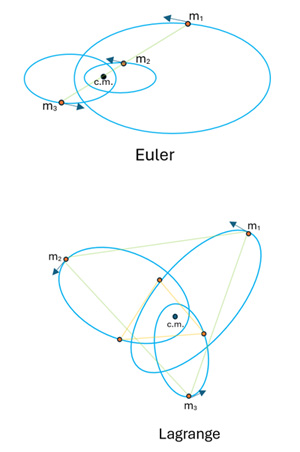

Ao contrário do que acontece na teoria de gravitação de Newton, na Teoria da Relatividade Geral o problema de 2 corpos não é exatamente solúvel!

Desde a sua proposição em 1915 a Teoria da Relatividade Geral tem sido um sucesso fabuloso, fazendo previsões incríveis que modificaram completamente a nossa compreensão do universo. Vejamos alguns exemplos.

*Precessão do periélio de Mercúrio. O cálculo teórico da precessão feito com a Relatividade Geral coincide com os dados astronômicos.

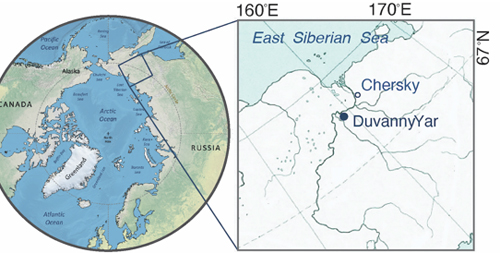

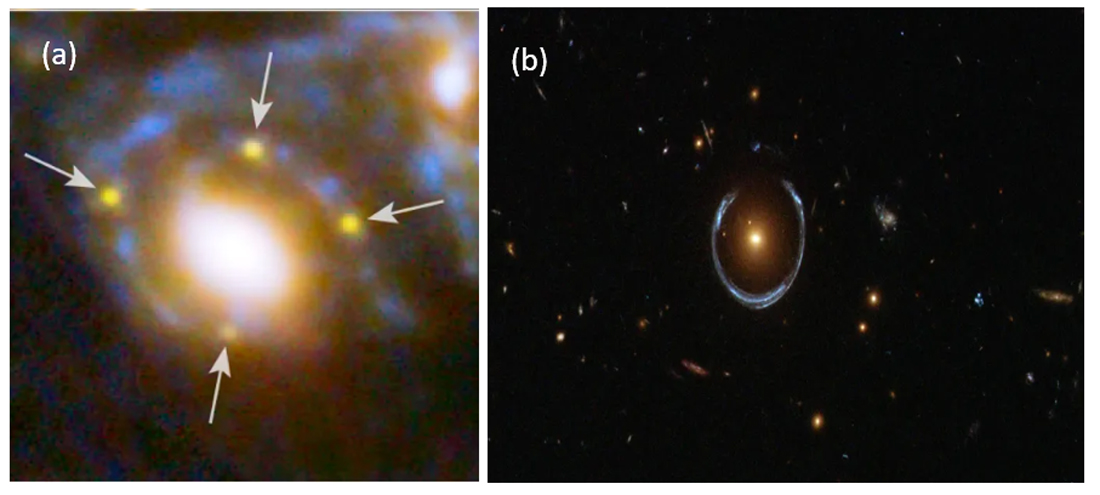

*Deflexão da luz. Ao passar nas proximidades de corpos massivos, um raio de luz é defletido, não segue em linha reta. Esse efeito foi observado pela primeira vez no eclipse solar de 1919 na cidade de Sobral, Ceará.

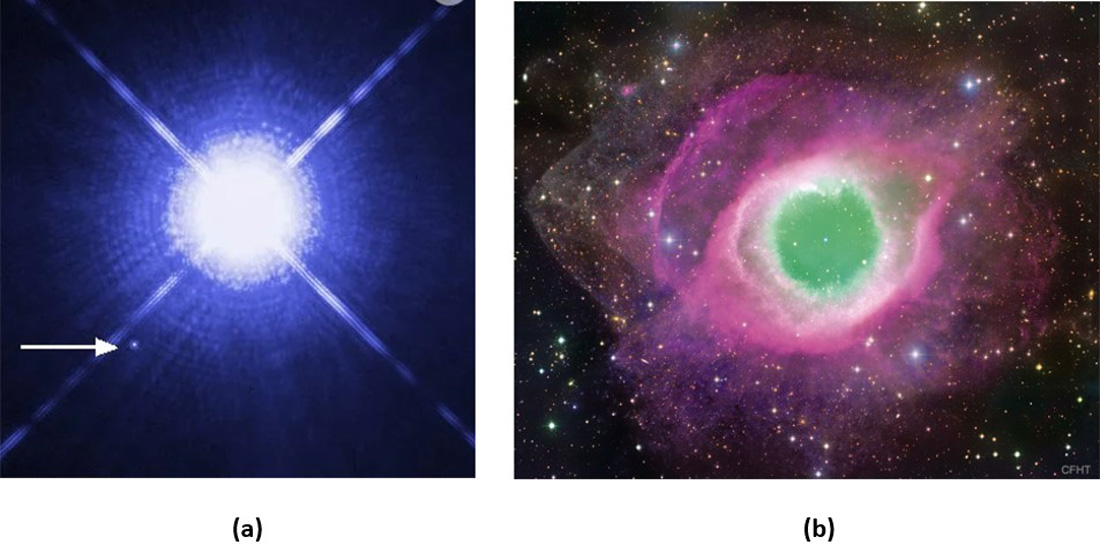

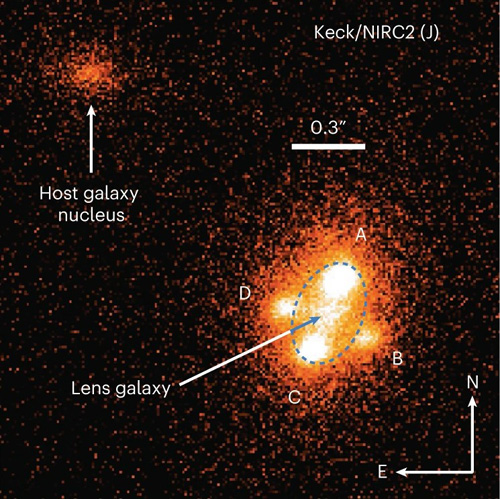

Figura 6 – Lentes gravitacionais podem ampliar imagens de astros muito distantes por fatores que vão de dezenas a centenas de vezes. (a) uma Cruz de Einstein de uma supernova distante 9,3 bilhões de anos-luz da Terra. Ela foi formada e distorcida por uma galáxia situada há 5 bilhões de anos-luz (a luz clara, no centro). (b) um Anel de Einstein (em azul) de uma galáxia situada há 10,8 bilhões de anos-luz, distorcida por uma galáxia (em laranja, no centro) com massa 10 vezes maior do que a da Via-Láctea. Crédito: NASA, ESA

*Lentes Gravitacionais. A deflexão da luz mencionada acima poderia transformar corpos celestes massivos em lentes de aumento, como telescópios naturais? Sim, a partir da década de 1980, o avanço tecnológico permitiu ver imagens magnificadas de objetos celestes muito distantes, como quasares e supernovas. A luz emitida por esses objetos, ao passar por galáxias muito massivas, é desviada e amplificada formando imagens como a Cruz de Einstein ou o Anel de Einstein. O Anel de Einstein só aparece quando o alinhamento entre o quasar, a galáxia defletora e a Terra é quase perfeito (Figura 6). As lentes gravitacionais já foram observadas nos comprimentos de onda de rádio, infravermelho, visível e até raios-x.

*Dilatação temporal gravitacional. Um relógio anda mais devagar na superfície da Terra do que a bordo de um satélite. Os 24 satélites que compõem o GPS (Global Positioning System) levam em conta esse atraso.

*Redshift gravitacional. A luz perde energia ao transicionar de um campo gravitacional intenso para outro mais fraco. Isto significa que ela fica mais vermelha. Em astronomia, esse fato é utilizado para estimar as massas de estrelas anãs brancas.

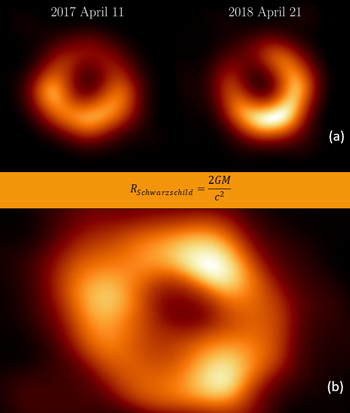

*Buracos negros. Para o caso de um corpo esférico e sem rotação o físico alemão Karl Schwarzschild encontrou, em 1916, uma solução exata da equação de Einstein. Nessa solução existe uma distância radial crítica (denominada raio de Schwarzschild e que é dependente da massa do corpo) a partir da qual a curvatura do espaço-tempo se torna tão grande que não existe mais uma trajetória pela qual uma partícula possa escapar, nem mesmo a luz! Um corpo celeste com essa massa e esse raio é um buraco negro. Como qualquer evento que aconteça no interior do buraco negro não é acessível ao mundo exterior, o raio de Schwarzschild é também chamado de horizonte de eventos.

Buracos negros que giram só foi resolvido exatamente em 1963 pelo matemático neozelandês Roy Kerr. Um buraco negro em rotação tem, para além do horizonte de eventos, uma nova superfície que delimita uma região chamada ergosfera. Nessa região, uma partícula é acelerada para a velocidade da luz. Suponha que uma partícula penetre tangencialmente na ergosfera, ela não será engolida no horizonte de eventos e, como a ergosfera aumenta sua energia, ela poderá se afastar com mais energia do tinha quando se aproximou do buraco negro. Um buraco negro em rotação pode ser um gerador de energia (processo de Penrose).

Sobre a formação dos buracos negros estelares. Grandes estrelas, com massas 8 vezes (ou mais) a massa do Sol, contrabalançam a pressão gravitacional com a pressão de radiação proveniente da reação de fusão de elementos químicos. Numa primeira fase, núcleos de Hidrogênio se fundem formando Hélio que, por sua vez, se combinam para formar o carbono e assim por diante, até chegar ao Ferro. Aqui o processo cessa, pois a fusão de núcleos de Ferro absorve ao invés de liberar energia. Neste ponto, o núcleo da estrela extremamente massivo colapsa gravitacionalmente, explodindo numa supernova que pode produzir uma estrela de nêutron ou um buraco negro. Se a massa da estrela progenitora estiver entre 8 e 25 massas solares forma-se uma estrela de nêutron e acima desse valor, forma-se um buraco negro.

A explosão da supernova retira muita massa das estrelas progenitoras. Até hoje, a maior estrela de nêutron conhecida tem apenas 2,35 massas solares enquanto o menor buraco negro encontrado possui 3,8 massas solares.

Figura 7 – Buracos negros não são visíveis, mas a matéria que compõe o disco de acreção que circunda o buraco negro está superaquecida e emite luz em várias frequências que vão do rádio ao raios-x. (a) à esquerda: primeira imagem de um buraco negro supermassivo (2017), com 6,5 bilhões de massas solares, e que fica na galáxia M87 (distante 53,5 milhões de anos-luz); à direita: um ano depois, a luz ficou mais intensa e se modificou indicando a enorme turbulência no disco de acreção. No centro: a relação entre o raio de Schwarzschild e a massa do buraco negro. (b) primeira imagem (2022) do buraco negro (Saggitarius A*) supermassivo que habita no centro da nossa Via Láctea (distante 27 mil anos-luz, na constelação de Sagitário), com cerca de 4 milhões de massas solares (Crédito: Event Horizon Telescope)

Em princípio, todos os buracos negros devem decair (evaporar), perdendo massa por radiação Hawking. Quanto menor a massa do buraco negro mais rapidamente ele decai. Até hoje, nunca testemunhamos o decaimento de um buraco negro – o menor deles, com 3,8 massas solares, levaria 1067 anos (o 1 seguido de 67 zeros) para decair, um número que é absurdamente maior do que a idade do universo de 13,8 bilhões de anos!

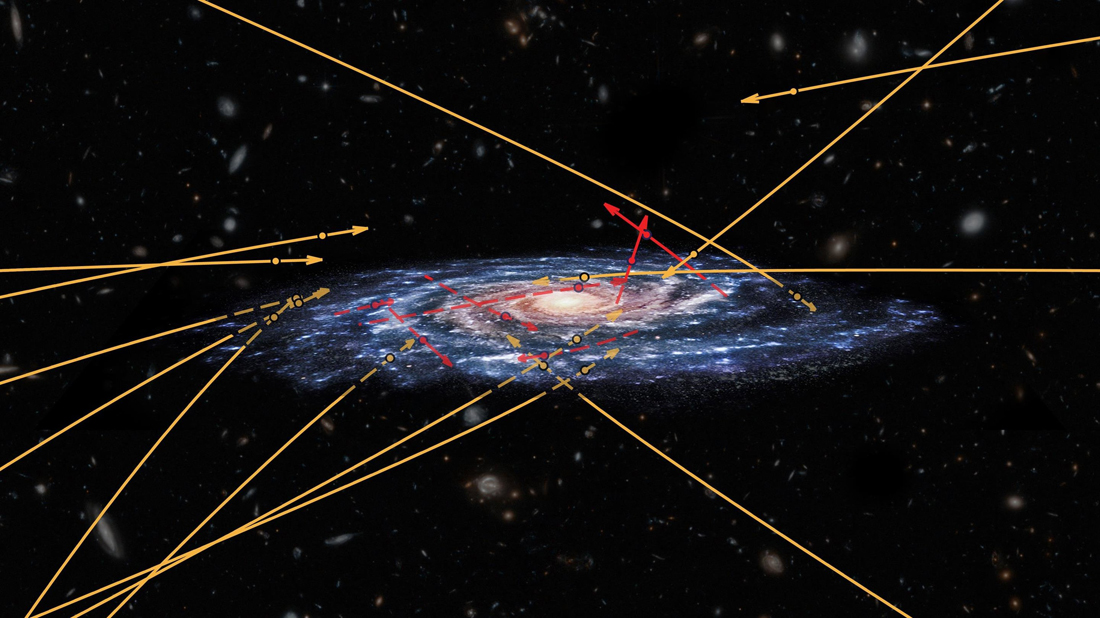

A descrição dada acima, refere-se à criação de buracos negros estelares. As maiores estrelas conhecidas têm, no máximo, até 200 massas solares. Entretanto, medidas de ondas de rádio (iniciadas na década de 1960) indicavam a existência de objetos celestes muito distantes, com comportamento típico de buracos negros só que com milhões e até bilhões de massas solares! Eram os quasares – galáxias distantes que possuem no seu centro buracos negros supermassivos muito ativos.

Hoje sabemos que, quase todas as galáxias têm em seu núcleo buracos negros supermassivos, incluindo a nossa Via Láctea (Figura 7). O maior deles é o TON 618, um quasar monstruoso que está a 10,4 bilhões de anos-luz da Terra e tem massa 66 bilhões de vezes maior do que a do Sol. Isso significa que ele tem um raio de Schwarzschild igual a 130 vezes a distância Terra-Sol. Como esses buracos negros supermassivos se formaram é ainda uma questão não resolvida.

Por último, gostaria de mencionar os buracos negros primordiais. No nascimento do nosso universo, ocorreu um processo chamado inflação (de curtíssima duração no tempo), no qual o espaço se expandiu exponencialmente com velocidade maior que a da luz. Durante este período, regiões mais densas podem ter colapsado e formado pequenos buracos negros primordiais. Um buraco negro com a massa da Terra teria o tamanho de uma moeda. Até hoje nenhum buraco negro primordial foi detectado, mas, há cientistas que acreditam que talvez isso seja possível quando o telescópio Nancy Grace Roman Space Telescope da NASA estiver operacional em 2027 (estimativa pré-Trump).

*Ondas Gravitacionais. As ondas gravitacionais tiveram sua existência prevista por Einstein em 1916. Elas surgem quando há grandes e rápidas variações de massas numa região do espaço. Uma vez que a massa curva o espaço, uma variação da massa também varia o espaço à sua volta criando uma onda gravitacional, que estica e comprime o espaço e se propaga com a velocidade da luz.

Em 2015, usando luz laser em interferômetros com formato de L, o LIGO (Laser Interferometer Gravitational Wave Observatory) detectou a passagem de uma onda gravitacional pela primeira vez. Um feito experimental extraordinário, pois, a variação espacial medida entre os braços do interferômetro foi de um milésimo do diâmetro de um próton! O evento que originou essa onda gravitacional foi uma colisão de dois buracos negros com 36 e 29 massas solares que, após a fusão, se transformou num único buraco negro com 62 massas solares. O equivalente a 3 massas solares se transformou em energia de radiação gravitacional.

Desde 2015, dezenas de ondas gravitacionais já foram detectadas envolvendo colisões entre buracos negros, estrelas de nêutrons e buracos negros com estrelas de nêutrons. Quem sabe, quando o Telescópio Einstein já estiver funcionando, será possível até detectar ondas gravitacionais oriundas de explosões de supernovas.

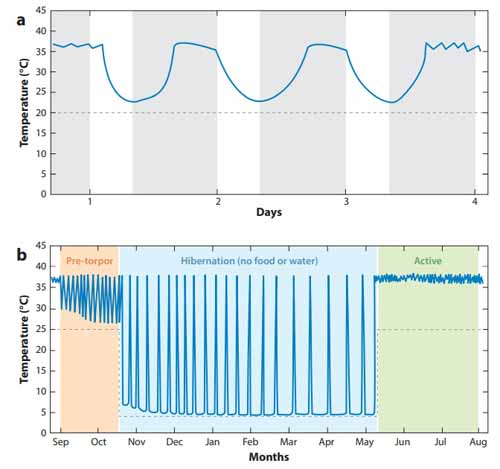

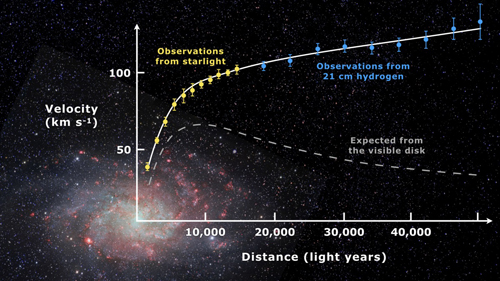

*Aceleração do Universo. Na equação de Friedmann (Figura 5), o sinal do parênteses (que contém a densidade e a pressão) é o que controla o destino do nosso universo. Para as 4 espécies que compõem o nosso mundo: radiação, matéria ordinária, matéria escura e energia escura, as densidades de energia são grandezas positivas. Dessa forma, elas contribuem para desacelerar o universo. As pressões feitas pela matéria ordinária e pela matéria escura também são positivas (e negligíveis, posto que não relativísticas). A pressão de radiação é sempre positiva e vale um terço da densidade de energia. Para que o universo esteja acelerando é necessário então, que a pressão da energia escura seja negativa e, além disso, dominante.

O fato de a pressão da densidade de energia escura ser negativa é consequência da invariância de Lorentz do tensor de momento-energia do vácuo (veja aqui). Além disso, medidas muito precisas da radiação cósmica de fundo em micro-ondas, demonstraram que o universo é composto por cerca de 70% de energia escura, 25% de matéria escura e 5% de matéria regular (bariônica). Resultado – o Universo está acelerando.

Apesar dos enormes sucessos das teorias quânticas de campos e da relatividade geral, elas possuem um ponto de conflito e incongruência – é o chamado problema da constante cosmológica (ou a catástrofe do vácuo).

Na Figura 5 temos as equações de Einstein no formato de 1998. A constante cosmológica, originalmente colocada do lado esquerdo (geométrico), está do lado direito (tensor momento-energia) e é interpretada como a densidade de energia escura. A energia escura é a responsável pela expansão acelerada do universo!

À luz da teoria quântica de campos, esse termo pode ser interpretado como oriundo das flutuações quânticas do vácuo. Essas flutuações correspondem a pares de partículas e antipartículas virtuais que estão sendo criadas e aniquiladas e dão origem à densidade de energia do vácuo. Identificar a densidade de energia do vácuo com a densidade de energia escura parece bastante natural, só que há um problema.

Estudando as explosões de supernovas tipo Ia, a radiação cósmica de fundo em micro-ondas e as oscilações acústicas bariônicas, obtém-se para a densidade de energia do vácuo o valor experimental de 6.10-10 J/m3. Entretanto, um cálculo analítico via diagramas de Feynman para a eletrodinâmica quântica resulta num valor teórico de 10110 J/m3, uma diferença exorbitante de 120 ordens de magnitude! Sobre isso foi dito que essa era ´a pior previsão teórica em toda a Física´.

*Físico, Professor Sênior do IFSC – USP

e-mail: onody@ifsc.usp.br

(Meus agradecimentos ao Sr. Rui Sintra da Assessoria de Comunicação do IFSC/USP)

Para acessar todo o conteúdo do site “Notícias de Ciência e Tecnologia”, clique aqui

Para acessar todo o conteúdo do site “Newsletter – Ciência em Panorama”, clique aqui

Assessoria de Comunicação – IFSC/USP