Em uma matéria publicada pela revista Galileu em julho de 2014*, a autora introduz, logo no primeiro parágrafo, uma interessante observação: “o aparelho de telefone que você tem no bolso tem o poder de processamento e a capacidade de armazenamento várias vezes maiores do que o computador gigante que você usava para entrar no ICQ em 2003. Aliás, o seu celular é mais poderoso do que o computador da NASA que levou o Apollo 11 à Lua”.

A observação acima nos faz refletir sobre como a tecnologia eletrônica avançou assustadoramente nas últimas décadas, o que nos motiva a entender como essa evolução se deu desde o princípio, começando pela produção massificada do primeiro transistor, em 1947. “A maneira como os computadores modernos operam, até a forma como eles são programados, fundamenta-se, predominantemente, no formato digital”, explica Luciano da Fontoura Costa, docente do Grupo de Computação Interdisciplinar do Instituto de Física de São Carlos (GCI-IFSC/USP).

Até a década de 1970, os aparelhos eletrônicos tinham seu funcionamento em grande parte voltado à captação e processamento de sinais analógicos que, até hoje, tem sua importância para o funcionamento de dispositivos específicos**. Mas, a partir desta década, os sinais digitais passaram a ocupar mais e mais espaço, por permitirem uma codificação da informação mais estável e menos sujeita a ruídos.

O primeiro marco

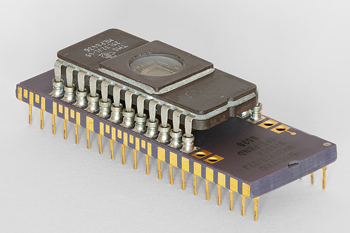

Microprocessador com EPROM (créditos: Wikimedia Commons)

Com o desenvolvimento dos transistores, os dispositivos eletrônicos passaram a ser produzidos em tamanhos e preços menores, envolvendo também menores gastos de energia. Os computadores, então, tiveram seu tamanho reduzido, enquanto suas capacidades de processamento aumentavam. Nessa linha evolutiva, os minicomputadores foram os primeiros a aparecer. Eles ainda eram grandes e caros (cerca de U$10 mil para cima, em configurações básicas), adquiridos principalmente pelo governo e empresas. “Para realmente viabilizar a produção em massa de computadores ao público geral, os circuitos integrados, conhecidos como microprocessadores, tiveram papel fundamental, já que essas peças continham diversos transistores em um único espaço, o que permitiu a produção de computadores pessoais pequenos e de custo acessível”, explica Luciano. “Os microcomputadores tinham como componente principal os microprocessadores, com um custo total bem menor que o dos minicomputadores”.

Esse novo modelo de funcionamento digital, uma quebra de paradigma na indústria da informática, foi sendo gradativamente extrapolado para os outros dispositivos eletrônicos (TVs, aparelhos de som, eletrodomésticos, aparelhos médicos, satélites etc.), que avançou fortemente até a década de 1980, e impulsionou o surgimento de diversos produtos e softwares mais flexíveis, a exemplo de editores de texto e planilhas. “Em particular, o lançamento dos jogos eletrônicos interativos deram grande impulso à engenharia eletrônica e à informática. Os usuários desses jogos sempre apreciaram a rapidez e o visual dos jogos, o que estimulou a melhora da parte gráfica e da velocidade de execução dos computadores. Algumas das ferramentas utilizadas hoje no meio científico, inclusive, derivam em parte do desenvolvimento desses jogos”, comenta Luciano.

Nova quebra de paradigma

Iniciada a década de 1980, computadores menores, mais baratos e multitarefas passaram a ser comercializados ao público. Mas a “grande sensação” viria no final da década, com popularização da Internet, que permitiria uma comunicação rápida, instantânea e, sobretudo, global. “O uso comercial público da Internet tem início em 1989, quando os computadores começam a ser interligados, primeiramente em empresas e universidades e, posteriormente, nos lares. Até então, dados eram compartilhados através de cartões de papel, fitas magnéticas e discos/disquetes”, elucida o docente.

A Internet evoluiu de discada para cabos ópticos e satélites e, assim como a evolução dos computadores, ela se tornou massificada e de baixo custo, e a velocidade de transmissão de dados também aumentou conforme os anos.

Entra em cena a inteligência artificial

Com a inserção da Internet no cotidiano de bilhares de pessoas, o compartilhamento de informações de maneira cada vez mais rápida é testemunhado – e testado – pela grande maioria das pessoas de forma contínua.

Créditos: Future of Life Institute

Mas uma nova Era na informática já teve início, e já podemos, inclusive, testemunhar esse novo momento, no qual tecnologias digitais, físicas e biológicas estão sendo completamente convergidas, dando origem à famosa “inteligência artificial”, que visa à criação de uma máquina que seja indistinguível do ser humano. “Esse é um dos grandes assuntos da atualidade”, afirma Luciano.

De acordo com o docente, os primeiros estudos dessa natureza remontam ao final do século XIX, passando por diversos ciclos, mas mantendo sempre a mesma motivação: emular o processamento neuronal humano e mimetizá-los nas máquinas. “E o caminho é estudar o sistema nervoso dos seres humanos, para entender como eles aprendem para, posteriormente, replicar isso nas máquinas”, explica o docente. “O chamado deep learning, fundamentado nas redes neurais, tem se mostrado muito promissor tanto para a resolução de problemas quanto para a própria pesquisa científica em todas as áreas do conhecimento”.

Cada módulo básico de uma máquina pode ser comparado a um neurônio humano, e o grande desafio para pesquisadores nessa área é fazer com que vários microprocessadores “conversem”, integrem-se e gerem ações paralelas. “Os neurônios coordenam diversas ações paralelas no organismo humano, como a fala, a digestão, a respiração etc. É como se tivéssemos vários ‘processadores’ realizando essas ações ao mesmo tempo. Os sistemas informatizados existentes possuem paralelismo a níveis ainda não comparáveis com o do sistema neuronal humano”, observa Luciano.

A próxima tendência

Entrando e saindo de foco durante as últimas décadas, os estudos de redes neurais já geraram diversos resultados. Atualmente, o “deep learning” é foco de atenção, explorando o processamento paralelo nas máquinas. “Com o avanço da tecnologia eletrônica, quase tudo hoje é automatizado, e geramos dados como nunca antes. Esses dados estão todos armazenados, e contém informação que pode levar à solução de uma infinidade de problemas. A questão que fica é: como extrair informações úteis dessa enorme quantidade de dados? A mineração de dados é um dos métodos para fazer esse filtro”, exemplifica o docente.

Uma das ações do “deep learning” é justamente analisar essa enorme quantidade de dados, e tentar tirar deles o máximo de informações possível. É uma nova ‘edição’ do paradigma neural que trabalhará com uma quantidade de dados jamais vista, inclusive tentando aprender automaticamente a partir das vastas quantidades de dados disponíveis. De acordo com uma matéria publicada no portal IFLScience, 90% dos dados mundiais hoje foram gerados nos últimos dois anos, com um geração diária de dados da ordem de 2,5 quintilhões de bytes.

Para se ter uma ideia de quão complexo é o desafio, a quantidade de estados binários dos neurônios que um ser humano possui é superior à quantidade de partículas elementares que existem no universo. Fica então fácil imaginar o quão desafiador é criar uma máquina capaz de gerar processamentos dessa ordem. Porém, as pesquisas indicam que estamos um pouco mais próximos de vencer esse desafio, que implicará em revisões ainda mais fundamentais do papel da informatização no mundo dos humanos.

*Matéria disponível neste link

**Sistemas de equações diferenciais, para simulações de aerodinâmica ou de estruturas, por exemplo, ainda funcionam com sinais analógicos

Assessoria de Comunicação- IFSC/USP